Por Mihaela Marín

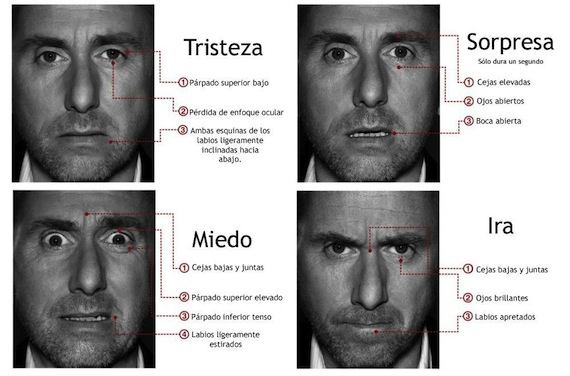

Ciudad de México, 17 de febrero (SinEmbargo/TICbeat).- Cuántas veces habremos sentenciado “¡Se te ve en la cara!” Seguramente lo hemos hecho en incontables ocasiones ya que lo que pensamos y nuestro lenguaje corporal tienen una relación muy estrecha. Es muy difícil esconder las respuestas emocionales a todos los estímulos que recibimos desde el exterior. Pero ¿de verdad podemos leer las emociones que expresan las señales faciales de los otros? Si hubiera sido posible, hasta ahora habríamos estado rodeados de marcas que habrían encontrado la clave de cómo abrir la puerta del deseo de los consumidores o de policías que se dieran cuenta de la culpabilidad de una persona de un vistazo durante los interrogatorios.

Y aunque de momento la idea pueda parecer poco verosímil, hay que señalar que no falta mucho hasta llegar a este punto, más aún si miramos la competición que existe para conquistar la mente de los usuarios a la que se han alistado nuevas startups que apuestan por algoritmos cada vez más entrenados a pasar la última frontera de nuestra intimidad e identidad: el cerebro.

El que más autoridad tiene con respecto a este tema es Paul Ekman, una de las voces más influyentes en la disciplina que se encarga del estudio de las expresiones faciales. Su catálogo de más de 5 mil movimientos musculares forma parte de un largo y profundo análisis que muestra como la más sutil arruga que altera la fisonomía de nuestro rostro puede revelar datos muy ocultos sobre el estado emocional de la persona. “Una vez sepas cómo funciona el sistema es algo extraordinario. No sólo te revela quién eres sino también qué sientes en el momento en el que estás hablando. Es la mejor ventana al cerebro”, afirma.

El sistema Facial Action Coding System que lleva perfeccionando desde los años ‘70 le ha permitido dar un paso más en la taxonomía de los movimientos faciales, además de estimular el apetito de conocimiento de las variables insondables de la psicología humana por parte de muchas startups. Entre estas, Emotient, Affectiva o Eyeris pretenden llevar sus descubrimientos a otro nivel con la ayuda de las nuevas tecnologías y la competencia científica del reputado psicólogo.

El último proyecto en el que están colaborando consiste en componer una gran base de datos sobre las emociones humanas con el fin de predecir las reacciones y comportamientos a gran escala. Emotient, una empresa reconocida por su sistema automatizado de reconocimiento facial, apoyó grandes compañías como Honda Motor o Procter & Gamble para medir las emociones de las personas durante las pruebas de los productos.

Para refinar su algoritmo, Emotient grabó las reacciones faciales de miles de personas de etnias muy diferentes que participaron en un estudio de marketing para sus clientes mediante el videochat. El resultado final se tradujo en un amplio depósito de 90 mil datos extraídos de cada fotograma, al final clasificados por categorías que van desde emociones que expresan ira o asco hasta alegría, sorpresa o aburrimiento.

Ahora intenta expandir su alcance con aplicaciones en el sector sanitario y retail. Un investigador de la Universidad de San Diego usa el software para comprobar el nivel de dolor en los niños con apendicitis, mientras que un comerciante ha querido emplear el sistema para medir el nivel de satisfacción de los clientes a la hora de comprar los productos en la tienda. Otro ejemplo es Affectiva, una empresa que declara haber medido 7 mil millones de reacciones emocionales de 2.4 millones de vídeos realizados en 80 países. La investigación le ha permitido ampliar el conocimiento sobre las diferencias de manifestación emocional en una gran variedad de perfiles. Por ejemplo, se ha llegado a la conclusión de que las mujeres sonríen más que los hombres y que los sudafricanos son los más expresivos.

PREOCUPACIONES DE PRIVACIDAD

Ahora los objetivos se dirigen a la integración de la tecnología en los sistemas vídeo. En este sentido Affectiva ya ha dado los primeros pasos y está colaborando con OoVoo LLC, un servicio de videochat que cuenta con 100 millones de usuarios.

Pero la lista no se acaba aquí. La automatización del reconocimiento facial ha empezado a ganar muchos más adeptos entre las empresas tecnológicas y la continua mejora de las investigaciones en computación y psicología han tenido mucho que ver con ello. Las posibilidades son mucho mayores que en el pasado. Se pueden crear mapas de emociones muy precisas que podrían ser útiles en el tratamiento de las enfermedades mentales como el autismo, pero también pueden generar aplicaciones que no encajan del todo bien en el entorno que defiende la privacidad de los usuarios como las de analizar el comportamiento por intereses puramente comerciales.

“No quiero que me analicen mis expresiones faciales cuando estoy caminando por la calle o cuando estoy en un supermercado. Es un terreno resbaladizo y en el cual ya estamos deslizando hacia la invasión de la privacidad, sin ni siquiera notificarlo. Yo sin duda no estoy de acuerdo con ello, especialmente si no me piden el permiso”, declara Ekman. El psicólogo, reconocido por ser una de las personas que mejor saben leer la cara de alguien, no niega que los algoritmos creados para interpretar las expresiones faciales casi en tiempo real podrían ocasionar abusos de datos muy sensibles y espera que la regularización sea una prioridad para las empresas que venden la tecnología de reconocimiento facial a terceros y sin la posibilidad de controlar su uso final.